Основные принципы и методы правильного индексирования сайтов

В этом курсе мы расскажем, как добавить сайт в Яндекс, грамотно управлять его индексированием и настраивать видимость вашего ресурса в поиске.

Как поиск узнаёт о сайтах?

//////////////////////////////////////////////////////////////////////////////////////////////////////////

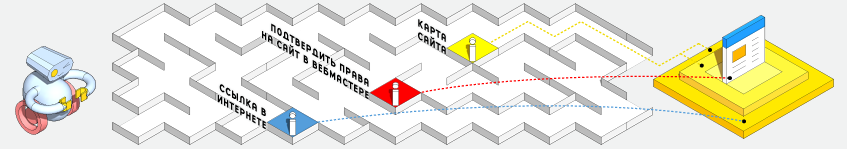

Для того чтобы сайт попал в поиск, поисковая система должна узнать о его существовании.

Кроме того, ей необходим доступ к ресурсу, чтобы его можно было проиндексировать. На этом уроке мы разберём, как поиск узнаёт о сайтах и как ему в этом помочь.

Наверняка вы знаете, что поисковая система собирает данные о сайтах и их контенте с помощью поисковых роботов.

Они неустанно обходят интернет, собирают информацию, обрабатывают её, а затем добавляют в поисковую базу. О новых ресурсах роботы чаще всего узнают, обнаруживая ссылки на незнакомые страницы. Если на просторах интернета есть ссылки на ваш сайт, роботы рано или поздно его найдут. Другое дело, что на это может уйти много времени. Поэтому гораздо проще сообщить поиску Яндекса о своём сайте через Яндекс.Вебмастер.

Яндекс.Вебмастер — это сервис, который позволяет следить за тем, как сайт представлен в поиске Яндекса. Чтобы сообщить Яндексу о сайте, достаточно добавить его в Яндекс.Вебмастер и подтвердить права на сайт.

Посмотрите, как это можно сделать:

Как сервер влияет на индексирование?

//////////////////////////////////////////////////////////////////////////////////////////////////////////

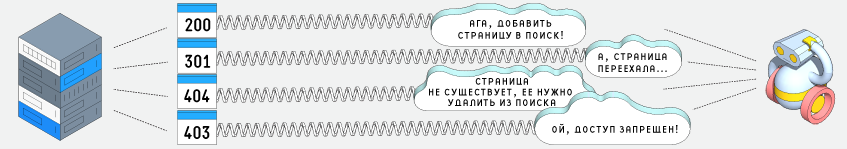

Чтобы попасть в поиск, сайт должен быть доступен для поисковых роботов. Иначе они не смогут его проиндексировать.

Одна из причин недоступности сайта — это сбой на сервере. В этом случае не только поисковые роботы, но и пользователи не смогут зайти на сайт. А если он будет недоступен продолжительное время, поисковые системы удалят его из своих баз, чтобы поддерживать их в актуальном состоянии. Поэтому важно следить за тем, чтобы сервер исправно отвечал на запросы.

Проверить, отвечает сервер или нет, можно на сервисе Яндекс.Вебмастер:

Если сайт отвечает на запрос и доступен для поискового робота,Яндекс.Вебмастер показывает статус 200. Остальные статусы передают какую-то другую информацию. Например, статус 404 обозначает, что запрашиваемая страница была удалена. Описание статусов можно найти в разделе«Помощь» сервиса Яндекс.Вебмастер.

У многих сервисов Яндекса есть свой поисковый робот.

Например, свой робот есть у Поиска, Яндекс.Картинок, Яндекс.Видео, Яндекс.Каталога. И у каждого робота свои задачи и правила работы. Иногда сервер может быть настроен так, что он пропускает на сайт основной робот Яндекса, но не жалует роботов Яндекс.Видео и Яндекс.Картинок — это значит, что контент сайта, скорее всего, не попадёт на эти сервисы. Поэтому, если вы заметили, что какой-то тип контента плохо индексируется, проверьте, попадает ли нужный робот на ваш ресурс.

Как управлять индексированием сайта?

//////////////////////////////////////////////////////////////////////////////////////////////////////////

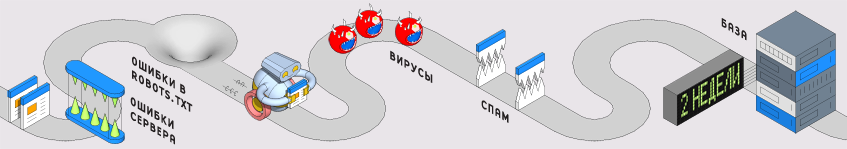

Владелец сайта может влиять на то, как индексируется его ресурс.

Например, вы можете запросто закрыть для поисковой системы определённые разделы своего сайта. Для этого нужно добавить соответствующие команды в файлrobots.txt — он находится в корневой папке сайта. Именно к этому файлу обращаются поисковые роботы, чтобы узнать, что можно индексировать, а что нет.

Поисковые системы исходят из того, что индексировать можно всё, что не запрещено. Поэтому владельцу сайта нужно самому позаботиться о том, чтобы в поиск не попала конфиденциальная информация — например, личные данные пользователей, их переписка или счета. Такие страницы нужно запретить индексировать. Рекомендуем также закрыть страницы со служебной информацией и страницы-дубликаты.

Многие системы управления сайтами (CMS) автоматически создают файл robots.txt и команды для роботов. Проверить, правильно ли настроены команды, можно на сервисе Яндекс.Вебмастер — с помощью инструмента «Анализатор robots.txt»:

Анализатор помогает найти ошибки в файле robots.txt, проверить, все ли команды прописаны верно и понятны роботу, и узнать, разрешена ли к индексированию конкретная страница.

Файл robots.txt позволяет закрыть для индексирования весь контент страницы. Если вы хотите закрыть только какую-то часть контента, используйте тег noindex. Этот тег не даёт индексировать заключенный в него текст, но не мешает поисковой системе переходить по ссылкам внутри текста.

Совет

Чтобы узнать, какие разделы сайта и в каком объёме уже проиндексированы, воспользуйтесь инструментом «Структура сайта» в Яндекс.Вебмастере.

Как сообщить поиску об изменениях на сайте?

//////////////////////////////////////////////////////////////////////////////////////////////////////////

Содержание многих сайтов меняется. Поэтому поисковые роботы регулярно их переобходят. Правда, новые данные попадают в поиск не сразу после переиндексации, а через какое-то время — при обновлении поисковой базы. Обычно это происходит 1-2 раза в неделю. Поэтому если вы только что открыли сайт или исправили опечатки в тексте, не беспокойтесь, что этих данных ещё нет в поиске.

Есть сайты, новый контент которых попадает в поиск очень быстро. К ним относятся крупные популярные ресурсы с часто обновляемой информацией — например, сайты СМИ. У Яндекса есть специальный быстрый робот, который индексирует такие ресурсы и сразу же добавляет свежие данные в поиск.

Поисковые роботы обычно сами определяют, какие страницы сайта необходимо обойти. Но вы можете им помочь.

Как люди используют карту, чтобы посетить все интересующие их места, так и роботы предпочитают двигаться по сайту с помощью специальной карты. Она называется Sitemap. Карта нужна для того, чтобы робот не пропустил какие-нибудь страницы сайта. Наличие такой карты особенно важно для крупных ресурсов со сложной структурой.

Чтобы робот мог пользоваться вашей картой, она должна быть не больше 10 МБ (в несжатом виде), содержать не более 50 тысяч страниц и располагаться в том же домене, что и включённые в неё страницы. Если карта не отвечает этим требованиям, можно разбить её на несколько файлов и указать их в файле индекса Sitemap.

Чаще всего карта сайта создается автоматически. Наиболее распространённые форматы карт —текстовый и XML. Яндекс поддерживает оба. Однако лучше использовать формат XML, потому что в нём есть дополнительные поля. Они позволяют указать значимость страницы, частоту её обновления и дату последних изменений. Давайте попробуем прочитать Sitemap, чтобы понять, какая информация там отражена.

Если карта сайта содержит ошибки, робот может воспринять её неправильно или вообще не сможет прочитать. Проверить карту легко на сервисеЯндекс.Вебмастер — с помощью инструмента «Валидатор файлов Sitemap».

Ссылку на карту сайта желательно разместить в robots.txt. Как вы знаете, для поисковых роботов этот файл обязателен для прочтения. После того как робот обнаружит карту сайта в robots.txt, она отобразится на сервисе Яндекс.Вебмастер. Вот как можно указать ссылку на Sitemap в robots.txt:

User-agent: *Allow: /

Sitemap: http://site.ru/sitemap.xml

Совет

Поддомены рассматриваются поисковой системой как отдельные сайты, поэтому нельзя размещать в Sitemap ссылки на страницы поддоменов. Для каждого поддомена нужно создать свою карту сайта.

Как узнать, присутствует ли страница в поиске?

//////////////////////////////////////////////////////////////////////////////////////////////////////////

Существуют разные способы понять, присутствует страница в поиске или нет.

Например, с помощью языка поисковых запросов. Если страница site.ru/page1 доступна в поиске, она появится по запросу url:site.ru/page1. Однако таким образом нельзя выяснить, почему страница не показывается. Возможно, она уже была в поиске, но потом пропала, или никогда и не индексировалась. Найти ответ на этот вопрос можно на сервисе Яндекс.Вебмастер, с помощью инструмента«Проверить URL».

Как удалить страницу из поиска?

//////////////////////////////////////////////////////////////////////////////////////////////////////////

Многих владельцев сайтов интересует, как удалить веб-страницу из поиска. Причины для этого бывают разные. Например, нужно убрать из поиска страницу, которой уже нет на самом сайте. Или в поиск попала конфиденциальная информация, которую владелец сайта забыл закрыть с помощью файла robot.txt. Давайте разберемся, как поступить в том и в другом случае.

Убрать страницу из поиска, не удаляя её с сайта, можно несколькими способами.

Например, указать в файле robot.txt , что страница запрещена к индексированию. Другой способ — закрыть контент страницы с помощью мета-тега noindex. При очередном обходе робот обнаружит, что страницу нельзя индексировать, и уберёт её из поисковой базы. О том, как правильно сделать запись в robot.txt, рассказано в уроке «Как управлять индексированием сайта».

Часто бывает так, что страница удалена с сайта, но по-прежнему доступна в поиске. Это значит, что поисковый робот ещё не добрался до страницы и не знает, что она удалена. Вы можете попросить робота зайти на эту страницу — с помощью инструмента «Удалить URL» на сервисе Яндекс.Вебмастер. Этот инструмент можно использовать и в том случае, если вы закрыли страницу для поисковой системы тегами или в файле robots.txt.

Совет

Если на сайте удалено сразу много страниц, то робот будет обнаруживать их постепенно —по мере обхода. Чтобы эти страницы быстрее исчезли из поиска, можно закрыть их для индексации в файле robots.txt.

Как работать с зеркалами сайта?

//////////////////////////////////////////////////////////////////////////////////////////////////////////

Зеркалами Яндекс считает сайты, которые на запрос робота возвращают один и тот же контент.

Как правило, на этапе создания у сайта уже есть одно зеркало, так как по адресам вида site.ru и www.site.ru обычно открывается один и тот же ресурс. При подключении защищенного протокола у сайта появляются новые зеркала — с префиксом https.

Кроме того, для ресурса могут быть зарегистрированы дополнительные адреса — например, относящиеся к другим доменным зонам или учитывающие опечатки. С дополнительных адресов пользователей могут перенаправлять на основной ресурс. Переадресация применяется также при переезде сайта на новое доменное имя.

Во всех перечисленных случаях сайты со временем будут признаны зеркалами друг друга, а в результатах поиска останется только главное зеркало.

Чтобы сменить главное зеркало сайта, достаточно указать желаемый адрес с помощью директивы Host.

Она должна быть задана в файлах robots.txt всех зеркал. Сообщить роботу о внесенных изменениях можно в Яндекс.Вебмастере. Для этого нужно зайти в раздел «Настройки индексирования», далее «Главное зеркало» и выбрать нужный домен из списка. Если этот домен там отсутствует, значит, он еще не был добавлен на странице «Мои сайты».

Возможна ситуация, когда домен уже добавлен в Вебмастер, но не отображается в списке зеркал. Это значит, что поисковая система еще не склеила его с другими зеркалами и воспринимает как отдельный ресурс. В этом случае менять главное зеркало не требуется. Нужно просто подождать, пока поисковая система склеит зеркала. Как и смена главного зеркала, склейка зеркал происходит раз в 1,5-2 месяца.

Как оценить качество индексирования сайта?

//////////////////////////////////////////////////////////////////////////////////////////////////////////

В поисковую базу попадают не все страницы сайтов.

Причины могут быть разные. Например, поисковая система посчитала страницу дубликатом или поисковый робот просто не успел до нее добраться. Насколько полно проиндексирован ваш сайт, можно узнать на сервисе Яндекс.Вебмастер. Он покажет, сколько страниц проиндексировано и сколько из них попало в поиск. Вы сможете узнать также тематический индекс цитирования ресурса (тИЦ).

Показатели индексирования сайта постоянно меняются.

Следить за изменениями можно на графиках, которые есть в разделе «История». Они помогают увидеть тенденции и вовремя на них отреагировать. Так, в большинстве случаев незначительное уменьшение количества страниц в поиске не должно вызывать беспокойства. Однако если при этом снижается количество переходов на сайт, лучше убедиться, что из поиска не выпали действительно важные и нужные людям страницы.

Графики позволяют понять также, успевает ли поиск за изменениями на сайте. Например, если вы добавили на свой ресурс несколько новых разделов, на графиках должен быть виден рост числа проиндексированных страниц. Если это не так, значит, новые разделы пока не доступны пользователям поиска.

Пока нет комментариев